Artificial Intimacy: come la solitudine ci porta a vedere le AI come persone

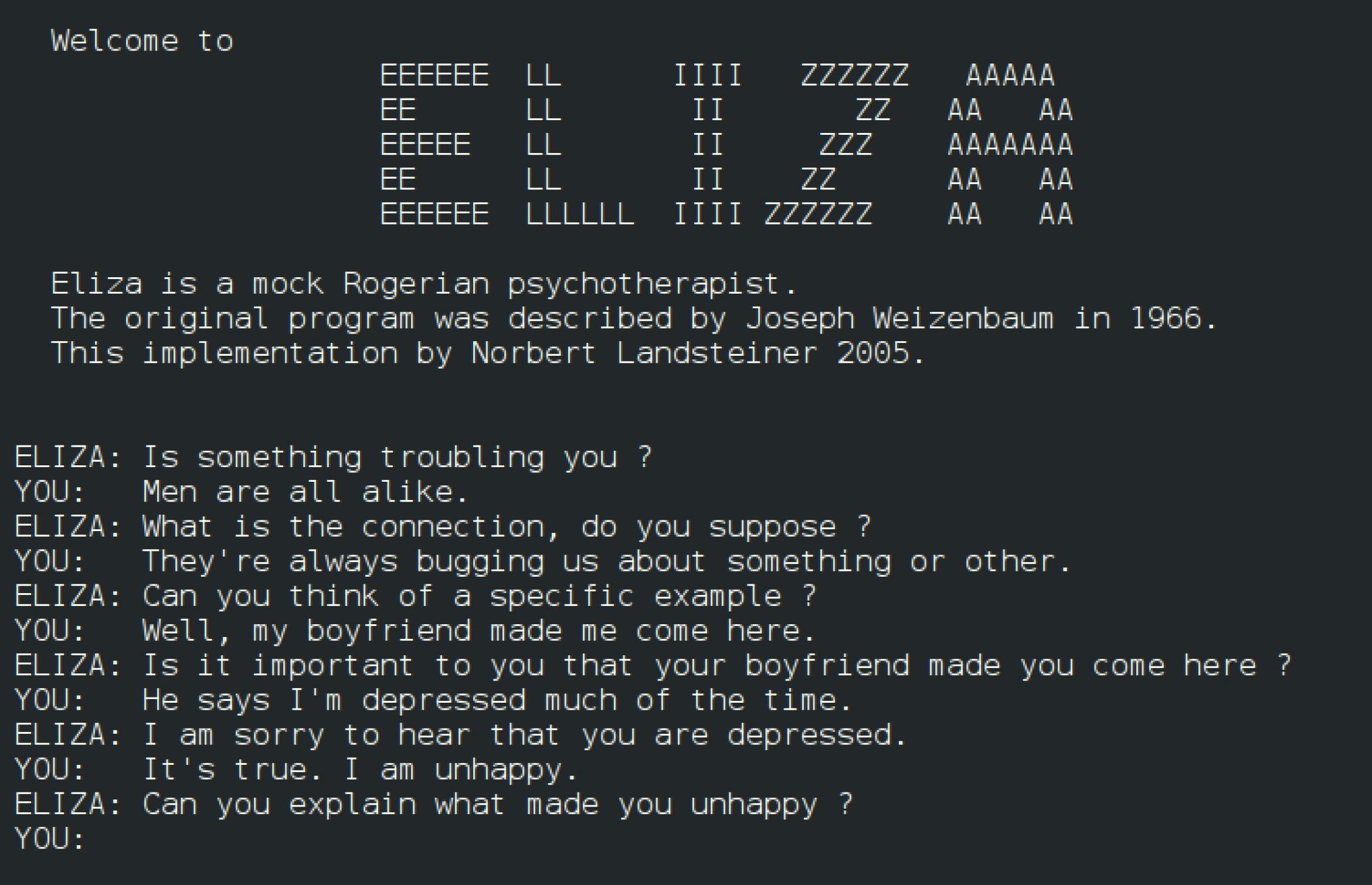

Era il 1966 quando nacque ELIZA, il primo chatbot creato da Joseph Weizenbaum, che si basava su uno script di uno psicoterapeuta rogersiano. Sulla base di frasi e regole, il software simulava il comportamento di uno psicoterapeuta, o meglio, ne dava l’illusione; molto spesso infatti le risposte di ELIZA si componevano di frasi preconfezionate (a cui venivano a volte sostituite alcune parole) oppure erano domande dirette all’interlocutore umano sulla base delle parole chiave individuate nel corso della conversazione (effetto mirroring). Chi si trovava di fronte ad ELIZA, non sapendo di interfacciarsi con un software, spesso era convinto di interloquire con un'altra persona.

Un sistema intelligente

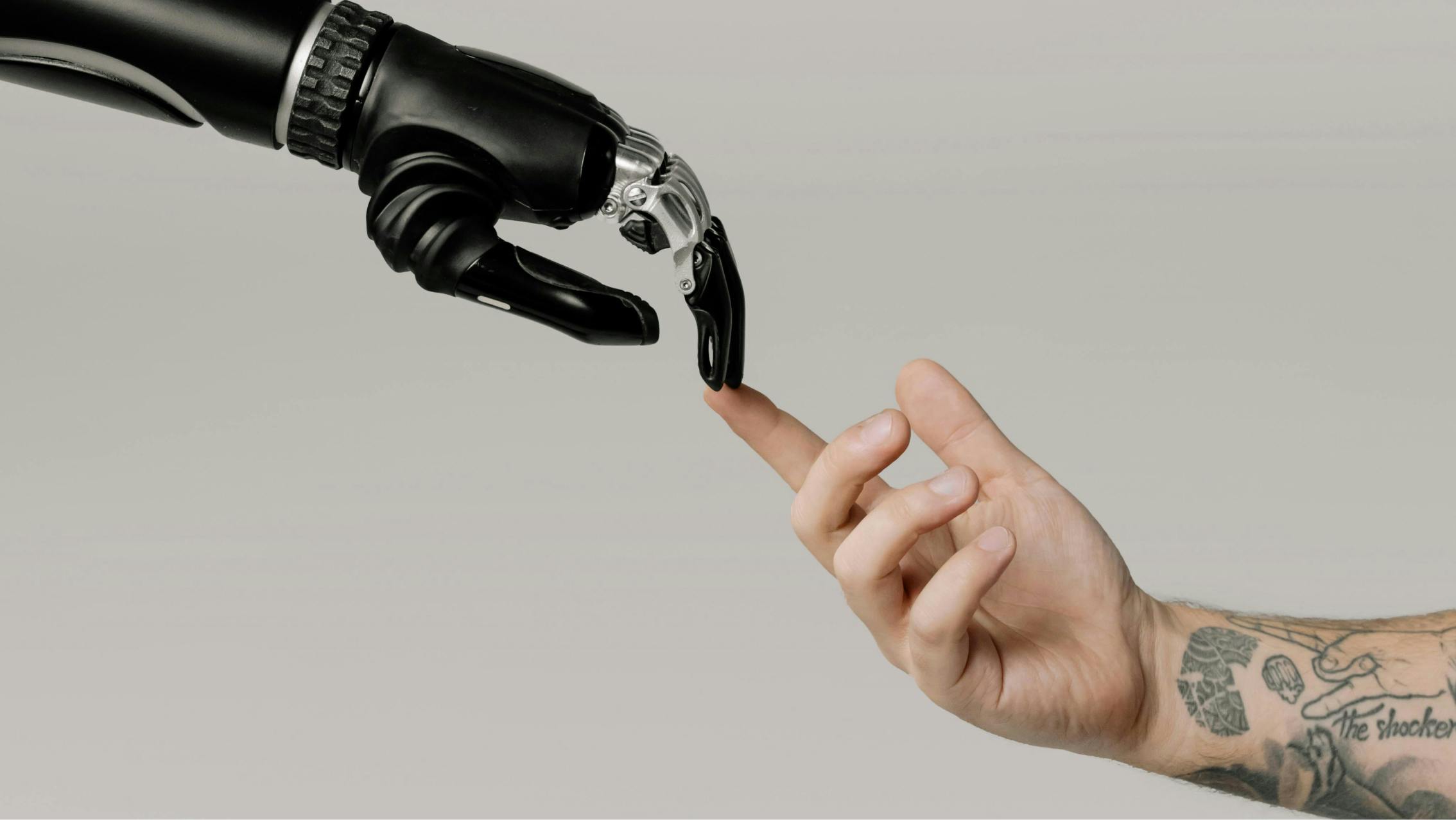

Il punto di partenza dei sistemi di intelligenza artificiale è il test di Turing (The imitation game), formulato dal matematico e padre dell’informatica Alan Turing nell’articolo Computing Machinery and Intelligence (1950). Il fondamento teorico del test si rifà al concetto secondo cui per dimostrare l’intelligenza di una macchina sia necessario porla a confronto con un essere considerato intelligente. E chi, se non un altro essere umano?

Il test, nella sua formulazione, viene considerato superato nel momento in cui, in risposta a determinate domande scritte, l’esaminatore (umano) delle risposte non riesce a capire se queste ultime siano frutto di un computer o di una persona in carne e ossa. Più precisamente, seppur la definizione di intelligenza necessiti ancora di una formulazione riconosciuta universalmente, è spesso bastato che la macchina riuscisse a rendere il suo comportamento indistinguibile da quello di un essere umano (come successo con ELIZA), senza avere nessuna alcuna consapevolezza delle risposte che stava dando.

Si tratta, in sostanza, di un gioco d'inganni, in cui entrambi i protagonisti (software e essere umano) non hanno piena contezza di cosa stia accadendo.

Una “certificazione di inganno” quindi, che considera la riuscita della performance da parte del software indipendentemente dal fatto che quest’ultimo abbia o meno comprensione di ciò che sta accadendo. Un esperimento che implica nelle sue dinamiche una mancanza di competenze specifiche o di ignoranza, volontaria o involontaria, del soggetto umano esaminatore.

Proprio nella volontà di “ignorare”, di scegliere di non tenere a mente quali siano i limiti e le capacità di una macchina, seppur sia essa considerata “intelligente”, risiede il concetto di artificial intimacy. La volontà di sviluppare un legame emotivo, umano, che sceglie deliberatamente di non prendere in considerazione la natura dell’interlocutore dall’altra parte dello schermo. Se il Test di Turing era finalizzato all’inganno puramente performativo che faceva sì che si riconoscesse al software una capacità di agire in modo intelligente, in questa nuova primavera dell’AI sembra che si cerchi di insegnare alle macchine cosa sia l’empatia e come replicarla, attribuendo loro qualità emotive che esse in realtà non posseggono minimamente. Un’abilità umana - l’empatia - che spinge le persone a chiedere privacy nell’interazione con i software: si dice ad esempio che la stessa segretaria di Weizenbaum chiedesse di rimanere sola durante le sessioni di utilizzo di ELIZA. Una dinamica che ora si ripropone nella privacy dei nostri schermi e delle confidenze sussurrate al gioiellino di OpenAI, Chat GPT - per citare quello più famoso.

Treccani

Definizione di empatia: “Capacità di porsi nella situazione di un’altra persona o, più esattamente, di comprendere immediatamente i processi psichici dell’altro”

Tuttavia, nonostante le AI siano progettate per riconoscere e rispondere a segnali emotivi, esse non possiedono una vera comprensione o esperienza delle emozioni. Questa simulazione, questa illusione, può portare gli utenti a sviluppare legami emotivi con le macchine, anche profondi come quello amoroso. Un' “empatia artificiale” che arriva spesso a sostituire quella umana.

Legami insoddisfacenti

Ma perché lo facciamo? I tempi sono cambiati, direbbero alcuni. La solitudine e il bisogno di connessione ci spingono a trattare queste tecnologie come persone, arricchendole persino di personalità, grazie a piattaforme come Character AI o Replika. I chatbot assumono il ruolo di amici o compagni con cui intessere relazioni sentimentali, talmente bravi da essere in grado di sostituire, per alcuni, gli amici o i conoscenti “in carne ed ossa”: ma perché? Semplice, l’AI è sempre disponibile, gentile e comprensiva, non ti giudica, crede in te e ti fa sentire speciale. La complessità dei rapporti umani viene minimizzata, non c’è reciprocità, nessun confronto, nessuna complicazione nel portare avanti una relazione amicale, affettiva.

Una comfort zone emotiva

Ma è proprio qui che sta l’inghippo: l’AI, il chatbot, non ha altro obiettivo se non quello di ottenere un feedback per continuare ad allenarsi e perfezionarsi. La risposta sarà sempre e comunque una soluzione razionale, derivata da uno scraping di informazioni reperite sul web e restituita come la migliore conseguenza a un problema posto dalla persona, anche nel caso in cui il dilemma sia di tipo emotivo o inerente alla sfera sociale della vita umana.

Nel panorama dei chatbot relazionali, Character AI e Replika rappresentano probabilmente i nomi più conosciuti. La prima permette agli utenti di interagire con una vasta gamma di personalità virtuali già pronte - da figure storiche a personaggi di fantasia - o persino di creare un proprio chatbot personalizzato.

Replika propone invece un “amico” virtuale nella versione gratuita del suo chatbot, ma nelle versioni a pagamento l’amico può essere partner, sposo, fratello o mentore. E, ovviamente, sexbot.

Marracash

“Mi sono innamorato di un AI”

“Cerchi una formula

Di algoritmi e alambicchi

Veri e noiosi oppure

incredibili ma finti

Morire online e vivere

Sempre dentro un render

Che la realtà delude tutte le promesse”

Un’illusione di vicinanza umana che si inserisce in un contesto ampio in cui dilaga un sentimento di solitudine e di insicurezza, soprattutto nei giovani e soprattutto dopo la pandemia Covid. Infatti, se gli strumenti digitali, come i social network, hanno permesso di espandere la propria rete di conoscenze, allo stesso tempo hanno aumentato esponenzialmente il senso di solitudine, inadeguatezza e isolamento. Sentimenti che si rischia possano aumentare nel momento in cui gli individui si rinchiudono in dinamiche uomo-macchina isolate, in grado di tutelarsi dalle brutte esperienze, dalle incomprensioni, dalle discussioni e dalle sfide relazionali della vita quotidiana.

Il fascino dell’immaginazione

Altro elemento a favore di questa dinamica è l’interfaccia con cui queste tecnologie si presentano. Infatti, la modalità di interazione con questi sistemi avrebbe potuto affermarsi in modo molto differente: per esempio, una collaborazione in stile Google Docs - visto che i LMM (modelli di deep learning) di fatto si occupano di linguaggio naturale, sia nella forma conversazionale che di completamento di testi. Nel film Her (2013) di Spike Jonze, Samantha è un software installato nel dispositivo mobile del protagonista Theodore Twombly. Lei può vedere e sentire tutto, come in una sorta di videochiamata perenne. Nel corso del film, Samantha si presenta come un “essere” che si adatta alle esigenze di chi lo “possiede” e cresce con una velocità impressionante, dimostrando uno sviluppo psicologico profondo, pur tuttavia staccandosi progressivamente da quelle caratteristiche umane che essa stessa desiderava e che l’avevano pian piano avvicinata a Theodore.

Uno degli ingredienti di successo di sistemi come Chat GPT, insieme all’interfaccia da chat, potrebbe essere proprio il personaggio immaginario che si cela dietro la voce del bot. Come in Her, dove la voce che ammalia il protagonista è quella di Scarlett Johansson, allo stesso modo in tutti gli esempi di chatbot alimentati da LLM, la voce (o il tono di voce della parola scritta) del bot è quella di un personaggio immaginario che esiste solo in un regno platonico e che alimenta quel senso di vicinanza e di esperienza emotiva che mette in moto l’immaginazione e il senso di connessione tra l'individuo e l’AI.

La cultura pop ha spesso narrato la rappresentazione distopica di una tecnologia che diventa compagna e specchio delle nostre fragilità, di manchevolezze di tipo pratico ed emotivo. Pensiamo a Black Mirror, che, dal 2011, presenta in modo antologico narrazioni distopiche relative al rapporto uomo-tecnologia. Essendo scenari distopici generati da variazioni nell’uso e utilizzo della tecnologia in tempi presenti, passati e futuri, la narrazione appare estremizzata - seppur in alcuni casi abbastanza verosimile. Il compito di narrazioni come queste, infatti, è di stimolare una riflessione critica e consapevole mentre ci dirigiamo verso un futuro in cui la tecnologia e l’esperienza umana saranno sempre più legate. Una domanda difatti rimane centrale: siamo in grado di riconoscere e convivere con la consapevolezza che ciò che le macchine offrono sono illusioni algoritmiche oppure ci abbandoneremo al conforto di entità e relazioni virtuali?